人工智能的历史起于远古时代,夹杂者神话故事和各种流言,正如帕梅拉( Pamela McCorduck)所说,远古人类创造AI 的初心是为了创造一个人造的上帝。比如希腊的金色机器人 火神赫菲斯托斯 和 Pygmalion’s Galatea。

远古时期

在公元前第一个千禧年,中国,印度和希腊哲学家都提出了一些推理的研究理论,比如 亚里士多德(Aristotle)进行了演绎推理三段论的完整分析,欧几里得(Euclid)所著Elements 是一种形式推理的模型,Muḥammad ibn Mūsā al-Khwārizmī, 发明了代数学,即我们现在所称的算法,此外还有欧洲哲学家威廉-奥卡姆,以及 Duns Scotus。

近现代

马略卡哲学家雷蒙-勒尔(Ramon LIull),通过一些逻辑方法发明了一些逻辑机器,莱布尼兹(Gottfried Leibniz) 收到他的启发,重新设计了前者的想法。

17 世纪, 莱布尼兹和托马斯-霍布斯(Thomas Hobbes),以及热奈-笛卡尔( René Descartes )向前更进一步,发现所有的思想都可以通过代数和几何的方式进行组织,Hobbes 写下了《Leviathan》,其中写道“推理无非就是计算”.

- 莱布尼兹设想了通过一种统一的描述性语言来进行推理,这样可以减少计算的论证过程,同时,在不同的学科之间也可以间少争论,更快的达成统一。

到了20世纪,数理逻辑的研究让AI 进一步实现了突破,以英国数学家布尔的《The Laws of Thought》和德国数学家弗雷格的《Begriffsschrift》为基础,拉塞尔和怀特海德在1913念出版了《Principia Mathematica》,在此著作中陈述了一种正式的处理数学基础的方法,德国数学家,大卫-希尔伯特,受到拉塞尔的影响,提出了一个影响数理推理的基础问题:是否所有的数学推理都能被形式化,进而进行分析?

这个问题后来在《imcompleteness proof》,图灵机理论以及《Lambda calculus》中得到了解答,对希尔伯特的问题,做了以下几个说明:

- 并不是所有数学逻辑推理问题都能得到解决,存在限制

- 在一定条件的限制范围内,任何形式的数学推理可以被自动化

在《Church-Turing Thesis》中提出了以’0’,’1’作为基本符号的设备,可以模拟任何可知的数学推理过程,即我们现在所熟知的图灵机理论。

计算机科学

19世纪初期,查尔斯-巴贝奇(Charles Babbage)设计了一种可编程的计算器(the Analytical Engine),艾达-拉芙蕾丝(Ada Lovelace)敏感的认识到这种设备所拥有的巨大作用,基于巴贝奇的计算器理论引擎,其编写了完整的计算伯努利数的方法,在后来,拉芙蕾丝也被公认为是计算机科学发展历史上的第一位程序员。

第一代的现代计算机是在二战时被用做密码破译机器,比如Z3,ENIAC 和Colossus,后两个是基于阿兰图灵的理论由 约翰.王.诺伊曼设计完成。

图灵测试

经过控制理论和早期的神经网络的发展,1950 年阿兰图灵发表了《computing machinery and intelligence》,其中,图灵预测了创造能够思考的设备的可能性,同时就设备具备思考能力进行了定义:

如果一个机器设备与人类对话时,人类完全不能分辨出其与人类的差别,那么就可以认为这类设备具备思考的能力

现在,图灵测试也被视作第一次对人工智能理论的正式论证。

1956年达特茅斯会议

1956年,Marvin Minsky, John McCarthy 和 2位顶级科学家: Claude Shannon (克劳德·艾尔伍德·香农)以及IBM的 Nathan Rochester,组织了达特茅斯会议,此次会议其中的一个提案断言:任何一种学习或者其他形式的人类智能都能够通过机器进行模拟。同时约翰·麦卡锡为这种机器智能取了一个名字:Artificial Intelligence, 由此,AI 第一次被正名。

黄金年代(1956–1974)

达特茅斯会议之后,大众对AI 赋予了很高的期望,也对AI 能起到的效果感到十分震惊,同时,相关的研究人员在公开场合和私底下都对未来的AI 发展表达了强烈的信心。政府部门,美国DAPA 向相关的AI 机构投注了大笔资金。 这种强烈的自信在整个社会蔓延,第一代AI研究者曾经作出一些预测:

- 1965, H. A. Simon 曾说道:智能机器在二十年内,将能胜任人类可以做的任何事情;

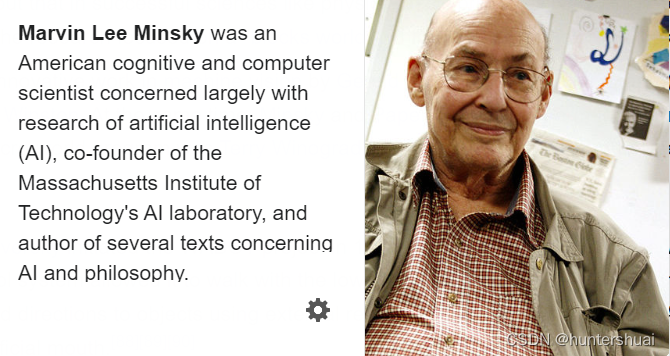

- 1967, Marvin Minsky: 通过一代人的努力,人工智能的相关问题将从根本上得到解决;

- 1970, Marvin Minsky (in Life Magazine): 3到五年内,我们将能创造媲美人类智能的通用人工智能。

同时,也有一些比较成功的人工智能应用铺展开来:

- 搜索推理 通过回溯和动态搜索,逐步的实现一个既定目标的方法,称之为搜索推理。可以应用于游戏对战和理论证明,其依据的还是基础的理论算法实现,通过启发式和经验式(heuristic & rules of thumb) 的方法可以优化搜索空间。

- 自然语言处理

AI 研究的一个重要目标是实现计算机的类人语言交流。早期比较成功的几个项目是:

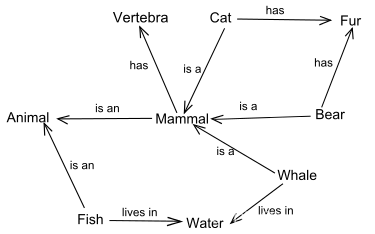

- 语义网络:Roger Schank 的conceptual dependency theroy 处理所有的英文单词为一个网络中的节点,单词间的语法作为节点间的连接;

- Joseph Weizenbaum 的 ELIZA 偶尔表现,让与其对话的人感觉是一个真人。但是事实上,ELIZA 不清楚自己在说什么,它只是机械的回答事前准备好的回答,结合一些语法规则重新组织这些表达,ELIZA 也被称为第一个chatterbot(对话机器人);

- 语义网络:Roger Schank 的conceptual dependency theroy 处理所有的英文单词为一个网络中的节点,单词间的语法作为节点间的连接;

- 微观世界

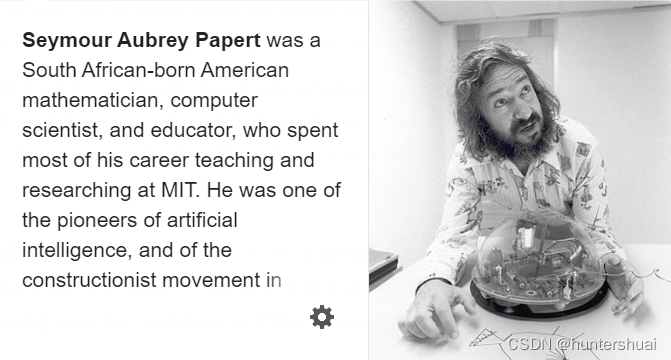

60 年代末期,MIT AI 实验室的 Marvin Minsky 和 Seymour Papert 提出AI 研究应该集中精力在微观世界的简单场景。他们认为类似物理世界中很多经典的原理都是基于理想的简化模型,比如完全无摩擦的飞机和完美刚体(rigid body)

黄金年代的各项成果也得到了财政方面的各项资助:

- 1963 年,MIT 收到了一笔2.2 百万 的资助,主要用于MAC 项目,其在5年前由Minsky 和MCCarthy 发起;

- DARPA 每年提供3 百万用于Newell 和Simon 在CMU 的项目以及John McCarthy 在Standford 的项目

- Edinburgh 大学由Donanld Michie 在1965 年创立的AI 实验室也获得了很多自助; 以上四个研究中心是那个年代主要的AI 研究战场,其获得的财政支持没有太多约束与要求,这些支持也创造了当时的Hacker 文化,让从业者可以天马行空式的进行发明创造,但是这种放手式的支持维持不了多长时间。

1993 ~2011 年:AI 的蛰伏期

AI 到这个时期,已经发展了近半个世纪,由于计算机的发展,终于在特定领域的一些孤立问题实现了一些它早期既定的目标。但也仅此而已,人工智能已经不是商业世界的宠儿,这个时期,AI 的发展比以往都要更加谨慎,但摩尔定律慢慢开始发挥作用。这个时期的主要事件:

- 1997 年的5月11 号,IBM 开发的深蓝计算机打败了Garry Kasparov;

- 2005 年,斯坦福大学的机器人在一个无人的非开放沙漠,自动驾驶了131 英里,赢得了DARPA Grand Challenge比赛;

- 2007 年,同样是DARPA Grand Challenge,CMU 团队城市环境中自主导航55英里并遵守交通障碍和所有交通法规而赢得了DARPA城市挑战赛

- 2011年2月,在Jeopardy!问答节目的展览比赛中,IBM的问答系统Watson以显着的优势击败了两位最伟大的Jeopardy!冠军Brad Rutter和Ken Jennings

- Judea Pearl 1988年的工作将概率和决策理论带进了AI 领域,基于此,许多新的数学理论和工具被引入:

- Bayesian network(贝叶斯网络);

- hidden Markov models (隐马尔可夫模型);

- information theory(信息论)

- stochastic modeling (随机模型)

- classical optimization(经典优化理论)

在此时期,AI 慢慢的成为了一个严谨且科学的学科,相应的数学表达也趋于统一,借助于AI 世界的语言,全世界的从业者都可以通力合作,分享思想和成果。同时,AI 以一种退居幕后的形式在:

- 数据挖掘;

- 医疗诊断;

- 搜索引擎; 发挥着作用。从业者为了度过这段蛰伏期,转而以类似信息科学,知识系统,感知系统和计算智能等别名来作为自己工作的分类。

这段时期是AI 黎明的前夜,当下所看到的AI 火山的喷发,这是在这段蛰伏期积聚了足够的力量。

现代人工智能的发展

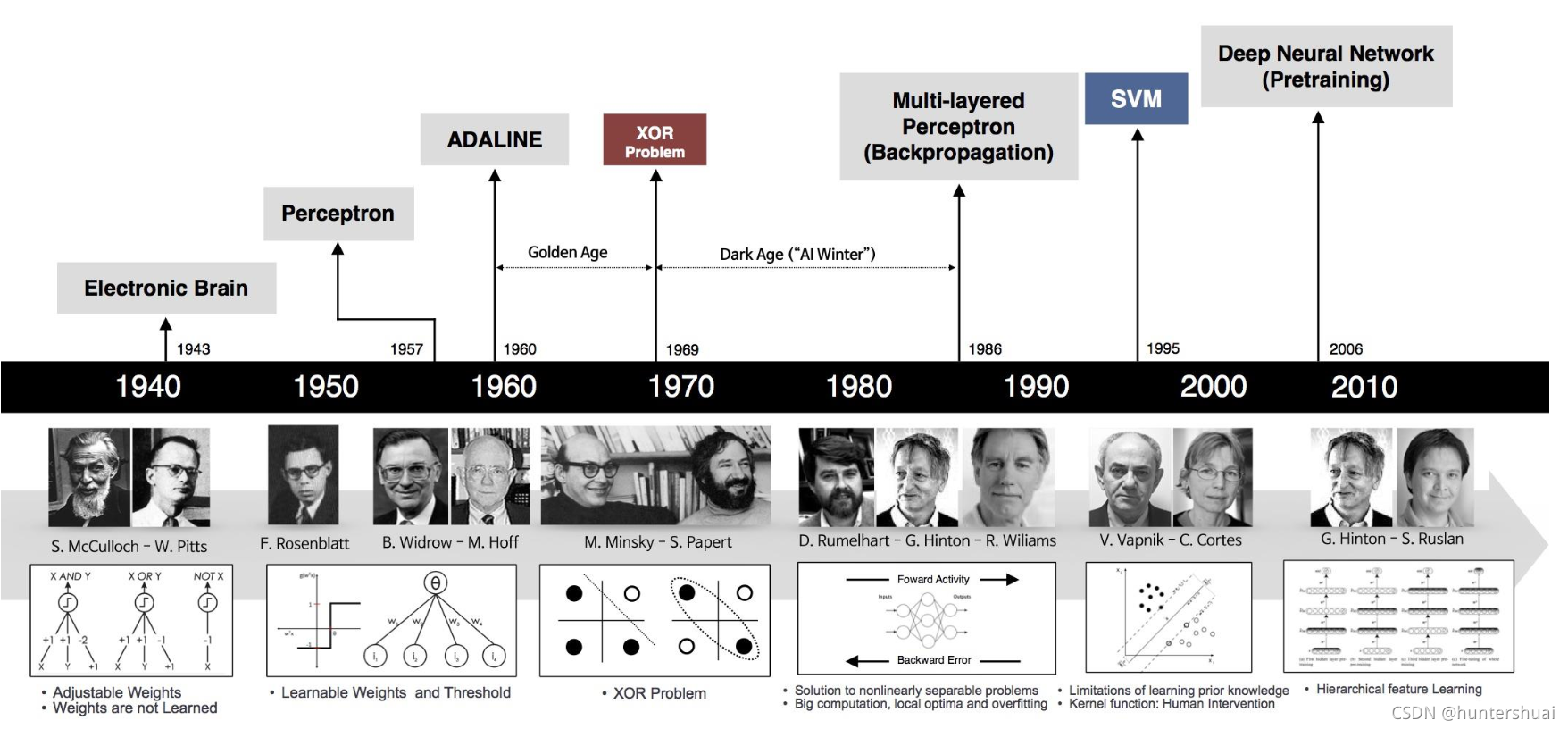

深度学习

深度学习是机器学习的一个分支,其使用多层网络来对更高层级的抽象进行建模,相比于shallow network(浅层网络),深度神经网络能对更为复杂的问题进行建模,同时避免shallow network 常遇到的overfitting(过拟合问题,当然深度学习网络也会遇到),同时,深度学习网络也有自身的弱点,对于RNN 来说,通常遇到的就是梯度消失问题(通过构建lstm 单元来避免)。

目前深度学习网络在计算机视觉和NLP 领域都有超出人类准确度的表现。

大数据

这里谈论到的大数据通常指使用常规软件工具在一定时间内不容易进行组织,收集和处理的数据。在《大数据时代》(Victor Meyer Schonberg & Kenneth Cooke)这本书中提到,大数据分析不是随机采样分析,而是对所有数据的分析。大数据具备5V 特性:

- Volume : 大容量

- Velocity :指向性

- Variety: 多样性

- Value: 具备价值,有用的信息

- Veracity: 真实性

通用人工智能

人类终极目标,智能皇冠上的明珠:通用人工智能(AGI),其能解决任何问题,而不是对特定问题的特定解决方案,也称为强人工智能(Strong AI)。 在相关领域,一些基础模型从2018 年开始在逐渐演进过程中:

- 2020 年,openAI 发布了GPT-3

- 2022年,DeepMind 发布了Gato

- 2023年,OpenAI 发布的GPT-4 代表着一个新时代的到来,微软基于这个模型构建了新版搜索引擎new bing,GPT-4 被普遍认为可以作为AGI 实现的早期版本,期待其后续的进一步进化演进。

- 未来以来,我们共同期待。。。

Reference:

- https://en.wikipedia.org/wiki/History_of_artificial_intelligence